Günümüz dijital ekosisteminde yapay zekânın yükselişi, internet trafiğinin niteliğini kökten dönüştürüyor. Artık sadece insanlar değil, otomatik sistemler ve yapay zekâ destekli botlar web sitelerine erişim sağlarken internet aktivitelerinin yönünü de değiştirmeye başladı. Bu dönüşüm, hem içeriğe erişim alışkanlıkları hem de web sitelerinin performans ve güvenlik stratejileri açısından yeni meseleler doğuruyor. Uzmanlara göre internet trafiği artık salt insan etkileşimine dayanmıyor; daha sofistike ve adaptif botların varlığı ile dijital dünya yeni bir evreye giriyor.

Web Trafiğinin Yüzde 51’i Artık Botlardan Oluşuyor

Son yıllarda yapılan siber güvenlik analizleri, internet trafiğinin önemli bir bölümünün otomatik sistemler tarafından oluşturulduğunu ortaya koyuyor. 2025 Imperva “Bad Bot Report” verilerine göre, dünya genelinde toplam web trafiğinin yarısından fazlası otomatik botlar tarafından oluşturuluyor. Bu raporda, özellikle “kötü niyetli” botların toplam trafik içinde %37’lik bir paya ulaştığı belirtiliyor. Bu, önceki yıllara kıyasla ciddi bir artış olduğunu gösteriyor.

Yapay zekâ destekli botların yaygınlaşması, esasen iki farklı boyutta ele alınıyor: web sitelerini bilgi toplamaya zorlayan ve kötü amaçlı erişim gerçekleştiren botlar ile gerçek zamanlı içerik çekerek kullanıcı sorgularına cevap veren yapay zekâ ajanları. Bu durum, içerik üreticileri için hem fırsatlar hem de riskler doğuruyor. Örneğin, bazı botlar klasik arama trafiğini aşarak doğrudan içerik özetleri çekebiliyor, bu da ziyaretçi sayılarının düşmesine neden olabiliyor.

Rapora göre AI tabanlı botlar artık sadece veri tarayıcıları olarak sınırlı kalmıyor; robot.txt gibi geleneksel engelleme yöntemlerini de aşabilen teknikler kullanarak engelleri aşabiliyor ve insan davranışını taklit eden trafik desenleri gösterebiliyorlar. Bu da botların tespit edilmesini gittikçe zorlaştırıyor.

Yapay Zekâ Trafiği İçerik Siteleri ve Arama Alışkanlıklarını Değiştiriyor

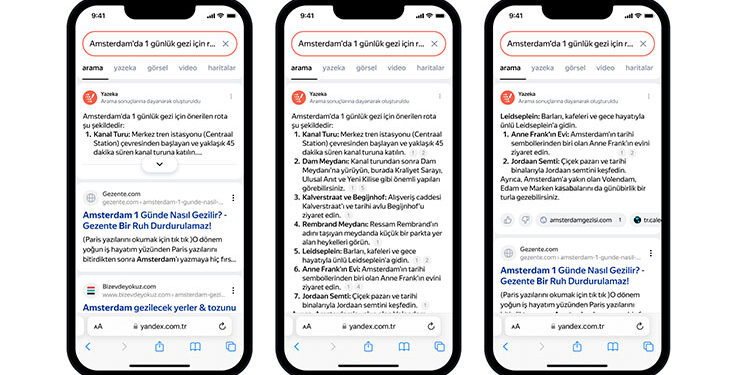

Yapay zekâ ile internet trafiğinde yaşanan bu dönüşüm, sadece bot sayılarını artırmakla kalmıyor, içerik tüketim modellerini de derinden etkiliyor. Özellikle haber siteleri, bloglar ve bilgi platformları, kullanıcıların geleneksel arama motorlarına girip sayfaları ziyaret etme alışkanlığının yerini yapay zekâ tabanlı araçlara bıraktığını görüyor. Bu araçlar, kullanıcı taleplerine yanıt olarak sayfalardaki içeriği özetleme ya da doğrudan cevap verme eğiliminde olduğu için, sitelere gelen organik trafik azalma eğilimi gösteriyor.

Örneğin yapay zekâ destekli arama sonuçları, kullanıcıların Google aramalarından doğrudan yanıt almasını sağlayarak tıklama oranlarını azaltıyor. Bu da internet sitelerinin gelir modellerini ve dijital pazarlama stratejilerini yeniden düşünmesine neden oluyor.

Benzer şekilde, bazı yeni tür yapay zekâ botları gerçek zamanlı içerik çekme yeteneğine sahip olup, web sitelerinde yasal izin gerektirmeden veri toplamak için gelişmiş rekabetçi teknikler kullanabiliyor. Bu da içerik sahiplerinin botlara karşı yeni güvenlik ve erişim kontrolleri geliştirmesini zorunlu kılıyor.

Botlar ve Yapay Zekâ: Dijital Ekosistemde Yeni Meseleler

İnternet trafiğinde yapay zekâ botlarının oluşturduğu yoğunluk, web sitelerinin güvenlik, performans ve içerik stratejileri üzerinde ciddi baskı yaratıyor. Geçmişte kalan geleneksel güvenlik önlemleri, bu gelişmiş botlara karşı yeterli olmaktan çıkarken; IP filtreleme ya da user-agent engelleme gibi klasik yöntemler, artık botları tespit etmekte zorlanıyor. Bu nedenle, web yöneticileri ziyaretçi ile bot arasındaki farkı ayırt edebilen daha sofistike güvenlik sistemlerine yöneliyor.

Bu durum, dijital platformlar için yeni bir “silahlanma yarışı” anlamına geliyor. İçerik üreticileri, botların içeriğe erişimini sınırlamalarla kontrol altına almaya çalışırken; aynı zamanda kendi içeriklerini bu yeni dünyada görünür kılmanın yollarını araştırıyor. Bazı şirketler yapay zekâ botlarına uygun SEO stratejileri geliştirmeye çalışırken, diğer yandan telif hakkı ve içerik kopyalanmasına karşı yasal adımlar atılıyor.

Web sitelerinin performans altyapıları da bu değişimden doğrudan etkileniyor. Yoğun otomatik istekler, sunucular üzerinde yüksek yük oluşturabiliyor ve bu durum hem maliyetleri artırıyor hem de sitelerin cevap verme sürelerini uzatabiliyor. Bu nedenle işletmeler daha gelişmiş trafik analiz ve kontrol araçlarına yatırım yapmak zorunda kalıyor.

İnternet trafiğinin giderek otomasyon odaklı hale geldiği bu yeni dönemde, insan odaklı içerik tüketimi ile makine odaklı veri erişimi arasındaki denge nasıl kurulacak, tamamen yeni çözümlerin ortaya çıkmasıyla belli olacak. Ancak şimdiden net olan bir şey var: Yapay zekâ ve botlar, internetin işleyiş şeklini ve dijital ekonomi modellerini kökten değiştirmeye devam ediyor.